같은 차원의 입력(26 * 26 * 32)과 출력(64)이 주어졌을 때 깊이별 분리 합성곱 층(SeparableConv2D) 의 파라미터 수와 일반 Conv2D 층의 파라미터 수를 비교했다. 각각 2400개 18496개로 나왔다.

'읽은 책 > 케라스 창시자에게 배우는 딥러닝' 카테고리의 다른 글

| 7.1 케라스의 함수형 API (p.312) (0) | 2022.03.18 |

|---|---|

| 6.4 컨브넷을 사용한 시퀀스 처리 (p.300) (0) | 2022.03.18 |

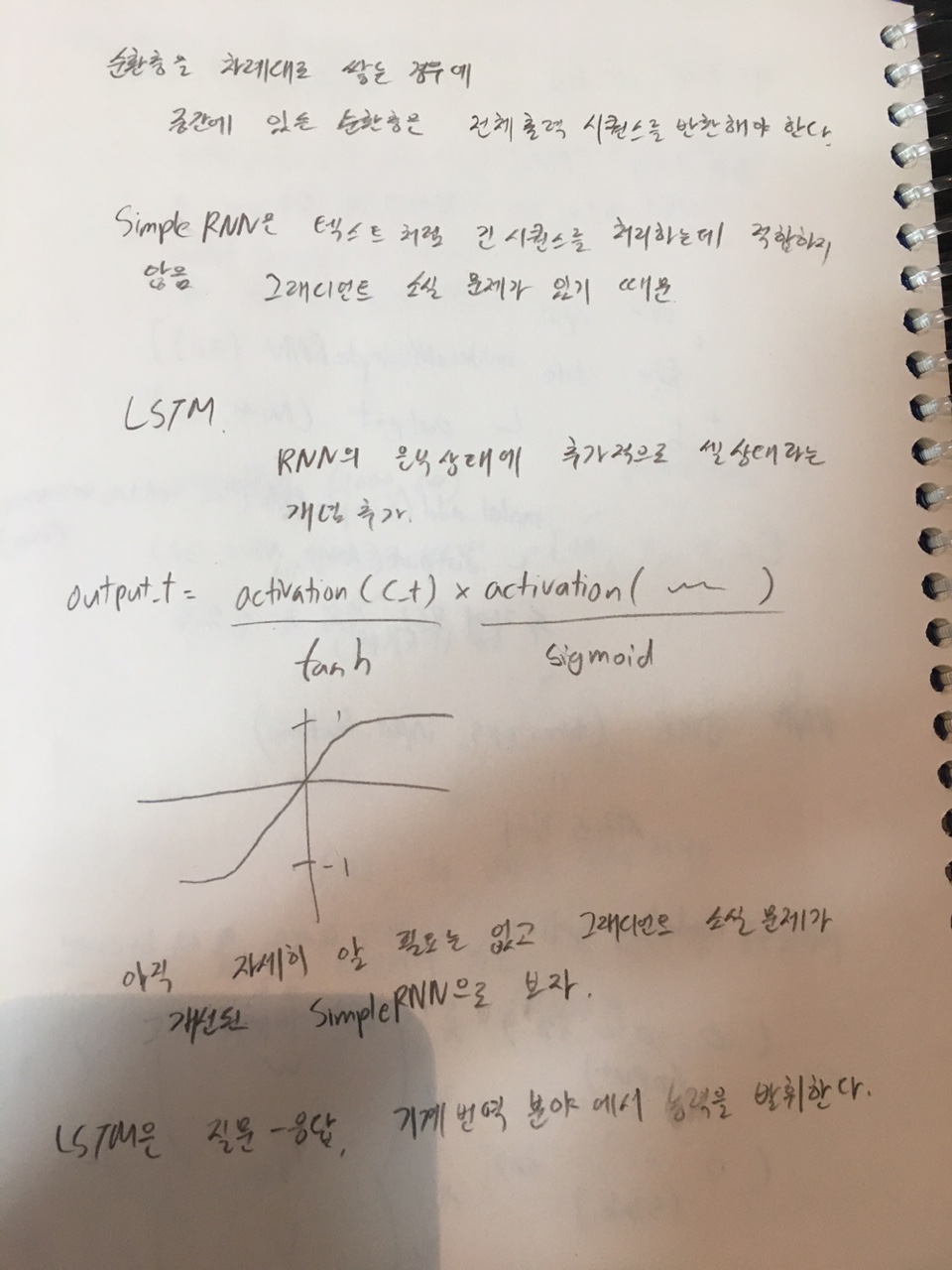

| 6.3 순환 신경망의 고급 사용법 (p.278) (0) | 2022.03.17 |

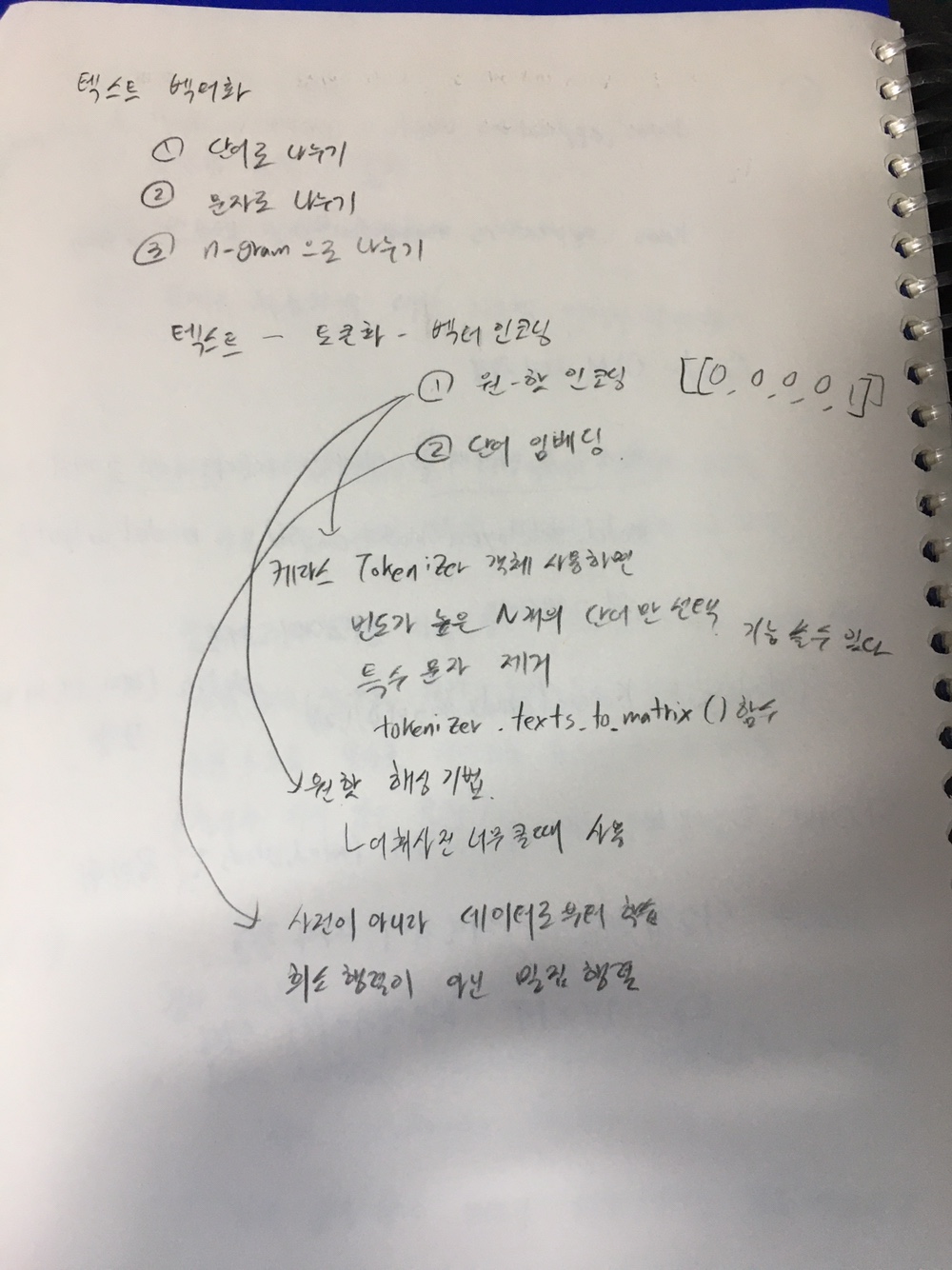

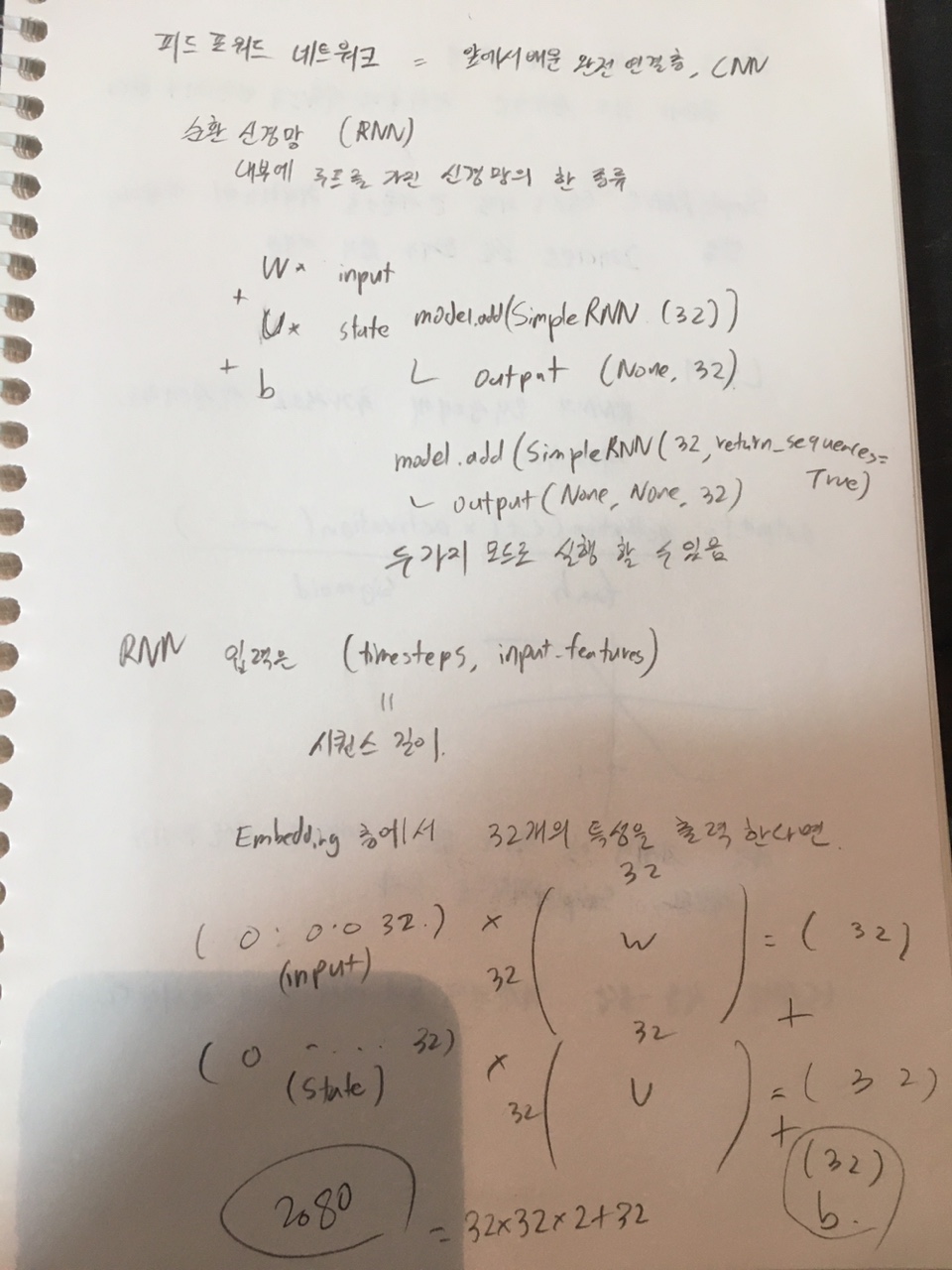

| 6.1 ~ 6.2 텍스트 데이터와 순환 신경망 이해하기 (p.244) (0) | 2022.03.17 |

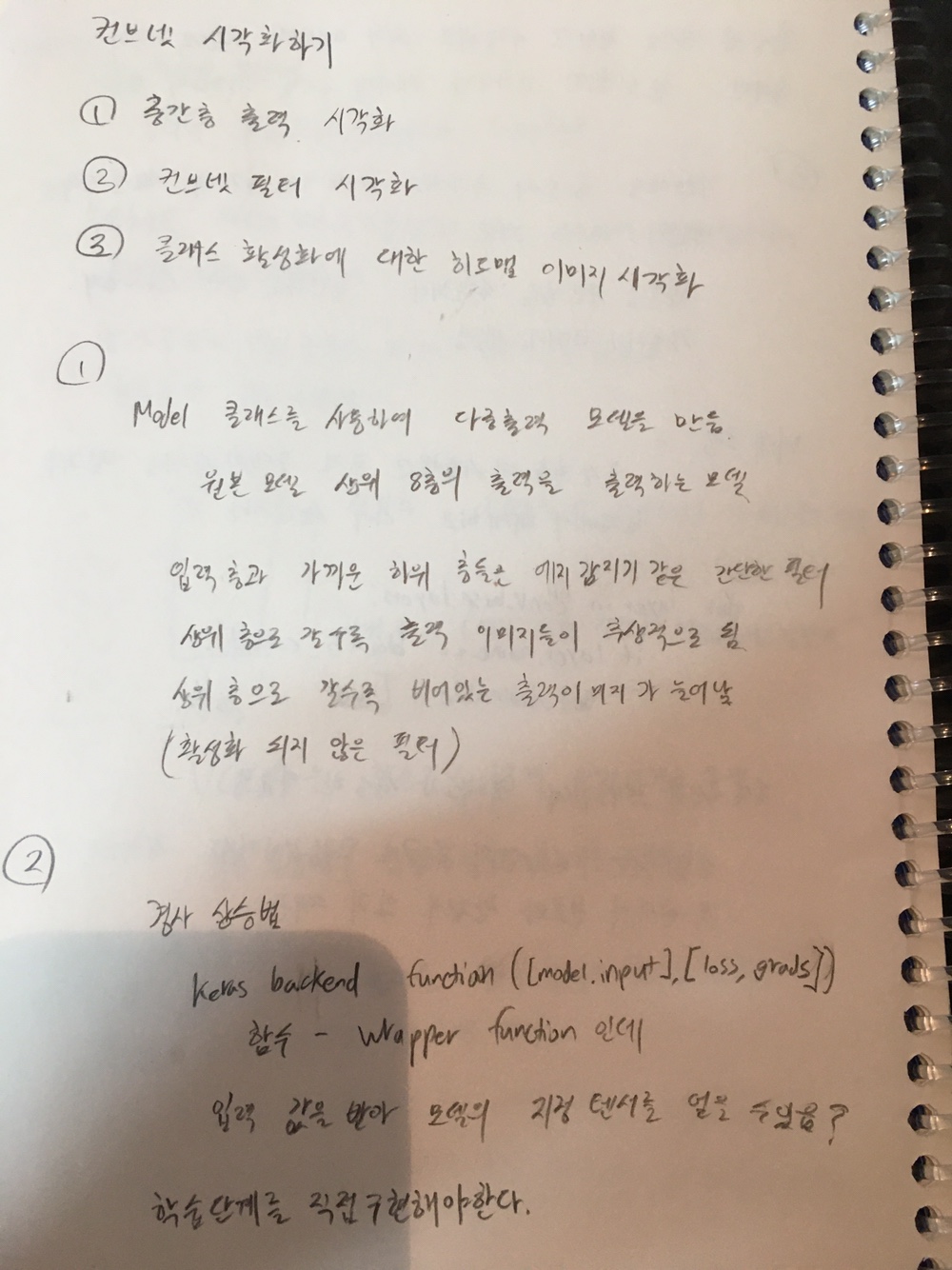

| 5.4 컨브넷 학습 시각화 (p.219) (0) | 2022.03.15 |